קובץ Robots.txt מאפשר למנהלי אתר Web לבקש מגוגל לא לאנדקס (לחסום) עמודים ודפים מסוימים באתר אינטרנט.

חסימת קישורים robot.txt

הקובץ הינו קובץ txt פשוט בו מכניסים שורת פקודה disallow ולאחר מכן את כתובת ה- URL של העמוד אותו רוצים לחסום.

מתי נחסום כתובת?

1. במצב בו גוגל מזהה 2 עמודים עם "כותרת" (title) או "תיאור (description) דומה. מצב זה הינו תקלה!

אסור ששני עמודים באתר יהיו עם כותרת או תיאור זהה. במצב כזה עליכם לתקן את העמוד הבעייתי > לבקש להסירו מתוצאות החיפוש > רצוי לחסום גם ב- robots.

2. אצלנו באתר 9comp היו כל מיני קישורים מ- yahoo group שלא היה ניתן להסיר באמצעות remove url רגיל של גוגל.

אלה קישורים לעמודים שהיו שייכים לדומיים 9comp בעבר. הוספנו את הקישור הבעייתי לקובץ הרובוט, ואחרי חודש הוא נחסם:

http://www.9comp.com/1154517411/3/23/18152/[email protected] (זה היה אחד מהקישורים הבעייתים).

3. אם סתם יש לכם עמוד מסוים שאינכם רוצים שגוגל יאנדקס ויציג בתוצאות

4. כאשר בונים אתר חדש ולא רוצים עדין שגוגל יאנדקס (יכיר) אותו, אפשר לחסום את כל האתר. מכניסים את הפקודה הזו

/ :Disallow

5. באתר WordPress יש תוסף מעולה בשם Ultimate SEO שמאפשר לקבוע כותרות ותיאורים לכל עמוד ספציפי. בתוסף יש גם אופציה לבקש בגוגל לא לאנדקס עמוד מסויים (ללא התעסקות עם robot).

שימו לב: קובץ הרובוט לא נועד לחסום Domains ספאם שמקשרים אליכם. במצב כזה, עליכם להודיע לגוגל על הדומיין הבעייתי עם כלי disavow

היכן הקובץ שמור?

אפשר למצוא את קובץ הרובוט בתיקייה הראשית ב- FTP.

בד"כ זו תיקייה בשם: Public_html או תיקייה בשם Public. יש שרתים שנקובץ נמצא בתיקייה בשם httpdocs.

שימו לב שיש מצב שהקובץ לא קיים אצלכם, אם זה המצב פשוט תצרו קובץ txt עם שם robots.txt

איך עורכים את הקובץ?

אפשר עם Notepad רגיל (כתבן) ומומלץ להשתמש עם עורכים מתקדמים כמו Notepad + +

https://notepad-plus-plus.org (צד שמאל תכנסו ל- downloads) – זה בחינם.

איך חוסמים קישור דרך robot.txt?

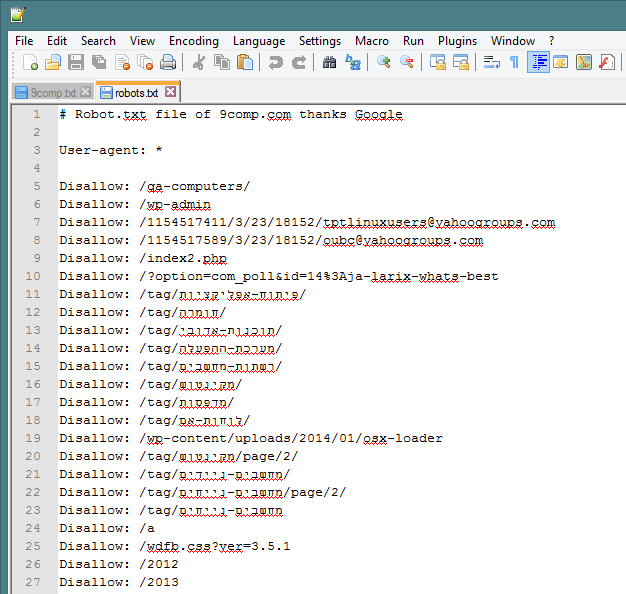

בחלק זה אציג לכם תמונה של קובץ robots.txt של אתר 9comp.com

בשביל לחסום, רושמים את המילה disallow ואחר מכן את הקישור ללא כתובת הדומיין!

tag/מקינטוש/ :Disallow (זה יצא הפוך, בדוגמא חסמנו את הכתובת של "תגית" ישנה באתר בשם מקינטוש).

תמונה לדוגמא:

קובץ robot.txt חסימה

שימו לב שהקובץ מתחיל עם שורה * :User-agent שפרושו תאפשר לספיידרים של גוגל לאנדקס את כל האתר. לאחר מכן disallow אומר, תחסום את קישור ככה וככה….

שימו לב שהקישורים ללא כתובת דומיין.